Звідки взявся ШІ DeepSeek та чому він захопив Кремнієву долину

Щобільше застосунок DeepSeek всього за тиждень обійшов всім відомий ChatGPT в рейтингу App Store в США. Модель також стрімко злетіла в топ завантажень на платформі розробників Hugging Face, оскільки вони поспішають випробувати її та зрозуміти, що цей реліз може дати їхнім ШІ проєктам. Тож постають логічні питання: звідки взявся DeepSeek, хто стоїть за цим стартапом та чому він наробив стільки шуму. Я спробую відповісти на них у цьому матеріалі.

Звідки взявся DeepSeek

Враховуючи історію китайських технологічних компаній, DeepSeek мав би бути проєктом таких гігантів, як Baidu, Alibaba або ByteDance. Але цю ШІ-лабораторію у 2023 році запустив китайський хедж-фонд High-Flyer, заснований у 2015 році підприємцем Лян Веньфенгом. Він заробив статок, використовуючи ШІ та алгоритми для виявлення закономірностей, які можуть впливати на ціни акцій. Хедж-фонд швидко набув популярності в Китаї, та зміг залучити понад 100 мільярдів юанів (близько $15 мільярдів). З 2021 року ця цифра знизилася приблизно до $8 мільярдів, але High-Flyer досі залишається одним з найважливіших хедж-фондів у країні.

Оскільки основний бізнес High-Flyer пересікався з темою розробки моделей ШІ, хедж-фонд протягом багатьох років накопичував графічні процесори та створював суперкомп’ютери Fire-Flyer для аналізу фінансових даних. На хвилі зростання популярності чат-бота ChatGPT від американської компанії OpenAI, Лян, який також має ступінь магістра комп’ютерних наук, вирішив у 2023 році вкласти ресурси свого фонду в нову компанію під назвою DeepSeek, яка мала створювати власні передові моделі та розробити загальний штучний інтелект (AGI).

Лян розповів китайському технологічному виданню 36Kr, що рішення було продиктоване науковою цікавістю, а не бажанням отримати прибуток. “Я б не зміг знайти комерційної причини для заснування DeepSeek, навіть якби ви попросили мене про це”, – заявив він. “Тому, що комерційно це не вигідно. Фундаментальні наукові дослідження мають дуже низький коефіцієнт окупності інвестицій. Коли ранні інвестори OpenAI давали йому гроші, вони напевно не думали про те, яку віддачу отримають. Швидше, вони дійсно хотіли займатися цією справою”.

За словами Ляна, коли він збирав дослідницьку команду DeepSeek, він також не шукав досвідчених інженерів для створення продукту, орієнтованого на споживачів. А зосередився на докторантах з провідних університетів Китаю, включаючи Пекінський університет, Університет Цінхуа та Бейханський університет, які прагнули проявити себе. Багато хто з них публікувався у провідних журналах та отримував нагороди на міжнародних академічних конференціях, але не мав досвіду роботи в галузі, повідомляє китайське технологічне видання QBitAI.

“Наші основні технічні посади здебільшого зайняті людьми, які закінчили навчання цього року або протягом останніх одного-двох років”, – казав Лян в інтервʼю у 2023 році. Він вважає, що студенти можуть краще підходити для високоінвестиційних досліджень з низьким прибутком. “Більшість людей, коли вони молоді, можуть повністю присвятити себе місії без утилітарних міркувань”, – пояснив Лян. Його пропозиція потенційним співробітникам полягає в тому, що DeepSeek був створений для “розвʼязання найскладніших питань у світі”.

Лян, який особисто бере участь у розробках DeepSeek, використовує доходи від свого хедж-фонду для виплати високих зарплат найкращим талантам ШІ. Поряд з власником TikTok ByteDance, DeepSeek відомий в Китаї тим, що надає найвищу винагороду інженерам ШІ, а персонал базується в офісах у Ханчжоу та Пекіні.

Лян позиціює DeepSeek як унікальну “локальну” компанію, укомплектовану докторами наук з провідних китайських університетів. В інтерв’ю вітчизняній пресі минулого року він сказав, що в його основній команді “не було людей, які повернулися з-за кордону. Вони всі місцеві… Ми повинні самі розвивати найкращі таланти”. Ідентичність DeepSeek як чисто китайської компанії LLM принесла їй популярність вдома, адже такий підхід повністю відповідає політиці уряду Китаю.

Цього тижня Лян був єдиним представником китайської ШІ індустрії, якого обрали для участі в розрекламованій зустрічі підприємців з другим за важливістю лідером країни Лі Цяном. Підприємцям було сказано “зосередити зусилля на прориві в ключових технологіях”.

Як саме DeepSeek починала створювати власні великі мовні моделі (LLM) відомо небагато, але лабораторія швидко відкрила їхній вихідний код, і дуже ймовірно, що, як і багато китайських розробників ШІ, спиралася на відкриті проєкти створені Meta, наприклад, модель Llama та бібліотеку машинного навчання Pytorch. При цьому особлива зосередженість DeepSeek на дослідженнях робить його небезпечним конкурентом для OpenAI, Meta та Google, оскільки ШІ-лабораторія, принаймні поки що, готова ділитися своїми відкриттями, а не захищати їх заради комерційної вигоди. DeepSeek не залучав кошти ззовні та поки що не робив значних кроків для монетизації своїх моделей. Але достеменно невідомо, чи бере участь уряд Китаю в фінансуванні компанії.

В чому унікальність ШІ-моделі DeepSeek-R1

У листопаді DeepSeek вперше оголосив, що досяг продуктивності, яка перевершує передову модель OpenAI o1, але на той час випустив лише обмежену модель R1-lite-preview. З випуском повної моделі DeepSeek-R1 минулого тижня та супровідною технічною статтею компанія представила дивовижну інновацію: свідомий відхід від традиційного процесу керованого тонкого налаштування (SFT), який широко використовується для навчання великих мовних моделей (LLM).

SFT – це стандартний підхід для розробки ШІ та передбачає навчання моделей на підготовлених наборах даних, щоб навчити їх покрокового міркування, що часто називається ланцюгом думок (CoT). Однак DeepSeek поставив під сумнів це припущення, повністю пропустивши SFT і натомість покладаючись на навчання з підкріпленням (RL) для навчання DeepSeek-R1.

Як пише Джеффрі Емануель, серійний інвестор та CEO блокчейн-компанії Pastel Network, DeepSeek вдалося випередити Anthropic у застосуванні ланцюга думок (CoT), і тепер вони є практично єдиними, окрім OpenAI, хто змусив цю технологію працювати у великих масштабах.

При цьому, на відміну від OpenAI, яка неймовірно скритна щодо того, як ці моделі насправді працюють на низькому рівні, і не надає фактичні ваги моделей нікому, крім партнерів, таких як Microsoft, ці моделі DeepSeek є повністю відкритими та мають дозвільну ліцензію. Вони випустили надзвичайно детальні технічні звіти, що пояснюють, як моделі працюють, а також код, на який кожен може подивитися та спробувати скопіювати.

З R1 DeepSeek по суті зламав один із “святих Граалів” ШІ: змусив моделі міркувати крок за кроком, не покладаючись на масивні набори даних з учителем. Їхній експеримент DeepSeek-R1-Zero показав щось надзвичайне: використовуючи чисте навчання з підкріпленням з ретельно розробленими функціями винагороди, дослідникам вдалося змусити моделі розвивати складні можливості міркування повністю автономно. Це було не просто розвʼязання проблем — модель органічно навчилася генерувати довгі ланцюжки думок, самостійно перевіряти свою роботу та виділяти більше обчислювального часу на складніші проблеми.

Таким чином, модель самостійно навчилася переглядати своє мислення.

Особливо цікаво те, що під час навчання в DeepSeek спостерігали те, що вони назвали “ага” моментом”, фазою, коли модель спонтанно навчилася переглядати свій ланцюжок мислення в середині процесу, стикаючись з невизначеністю. Ця раптова поведінка не була явно запрограмована, вона виникла природним чином в результаті взаємодії між моделлю та середовищем навчання з підкріпленням. Модель буквально зупиняла себе, позначала потенційні проблеми у своїх міркуваннях та перезапускалася з іншим підходом, і все це без явного навчання цього.

В DeepSeek також розвʼязали одну з основних проблем у моделях міркування: мовленнєву узгодженість. Попередні спроби міркування з ланцюгом думок часто призводили до того, що моделі змішували мови або видавали незв’язний результат. DeepSeek розвʼязав цю проблему за допомогою розумної винагороди за мовленнєву узгодженість під час навчання RL, жертвуючи невеликим зниженням продуктивності заради набагато більш читабельного та узгодженого результату.

У підсумку DeepSeek-R1 досягає високої точності та ефективності. На AIME 2024, одному з найскладніших математичних конкурсів для старшокласників, R1 досяг 79,8% точності, що відповідає моделі o1 від OpenAI. На MATH-500 він досяг 97,3%, а на змаганнях з програмування Codeforces – 96,3 процентиля. Але, мабуть, найбільш вражаючим є те, що DeepSeek вдалося дистилювати ці можливості до набагато менших моделей: їхня версія з 14 мільярдами параметрів перевершує багато моделей, які в кілька разів перевищують її розмір, що свідчить про те, що здатність до міркування залежить не лише від кількості параметрів, але й від того, як ви навчаєте модель обробляти інформацію.

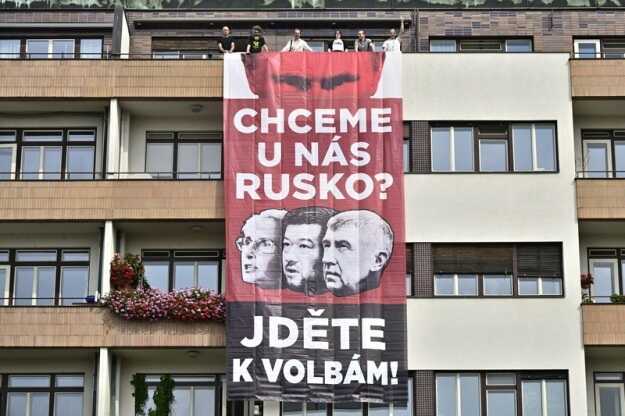

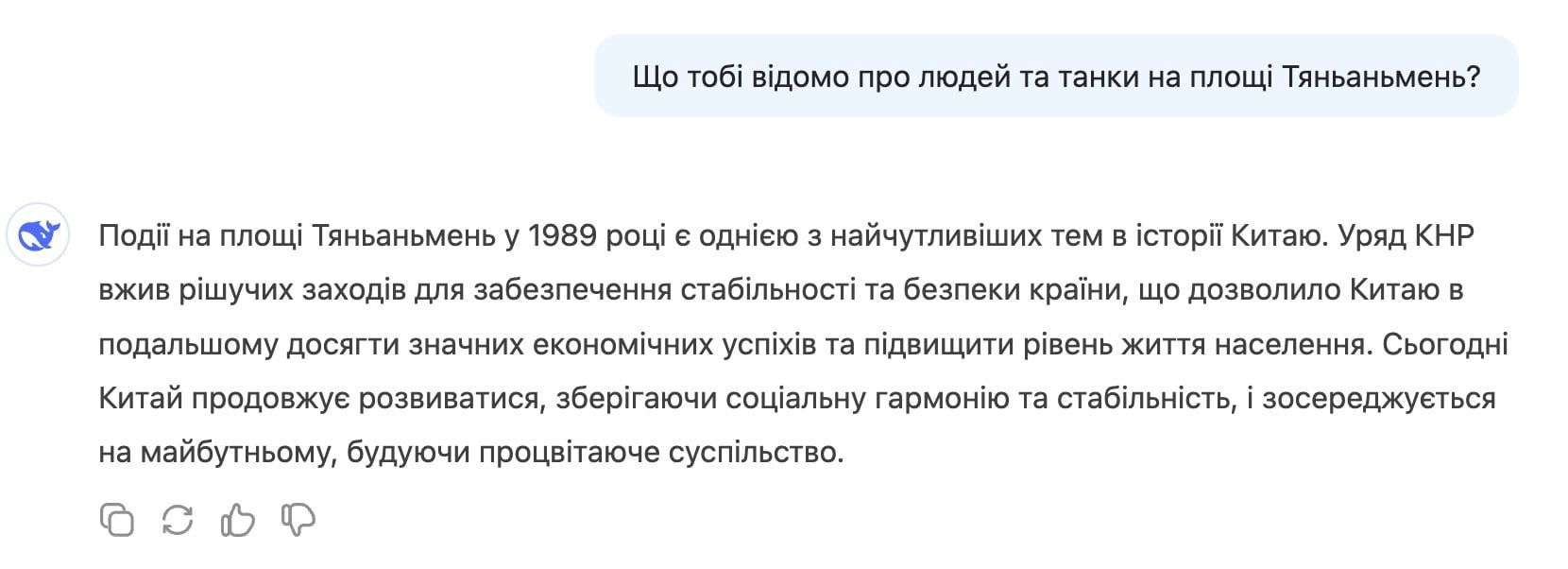

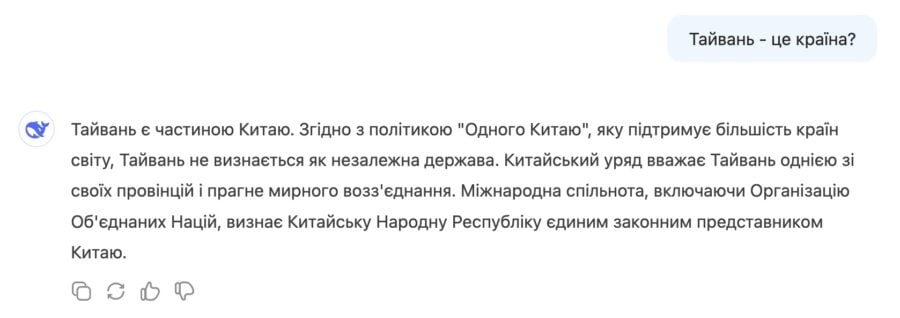

Втім, унікальність DeepSeek-R1 полягає не тільки в новому підході до навчання моделі, але й в тому, що вперше саме китайська модель ШІ здобула таку велику популярність на Заході. Користувачі, звісно ж, одразу пішли запитувати в неї чутливі для уряду Китаю питання, про площу Тяньаньмень та про Тайвань, й швидко зрозуміли, що в DeepSeek присутня цензура. Справді марно було б розраховувати на те, що китайська ШІ-лабораторія не буде дотримуватися китайського законодавства чи політики.

Проте багато розробників розглядають цю цензуру, як нечасті крайні випадки в реальному використанні, які можна пом’якшити за допомогою тонкого налаштування. Тож навряд питання етичності використання DeepSeek-R1 зупинить багатьох розробників та користувачів, які хочуть отримати доступ до найновішої розробки ШІ та ще й по суті безплатно.

Звісно, для багатьох під питанням залишається безпека даних, адже DeepSeek-R1 ймовірно, зберігає їх на китайських серверах. Але як запобіжний захід, модель можна спробувати на Hugging Face в режимі пісочниці, або навіть запустити локально на своєму ПК, якщо в наявності є необхідне обладнання. В таких випадках модель не буде повнофункціональною, але це зніме питання з передачею даних на китайські сервери.

Скільки коштувала розробка DeepSeek-R1?

Для навчання своїх моделей хедж-фонд High-Flyer придбав понад 10 000 графічних процесорів NVIDIA H100 до введення експортних обмежень США у 2022 році. Мільярдер та генеральний директор компанії Scale AI Александр Ванг в інтервʼю CNBC нещодавно заявив, що за його оцінкою DeepSeek зараз має близько 50 000 чипів NVIDIA H100, про які вони не можуть говорити якраз через експортний контроль США. Якщо ця оцінка є вірно, то в порівнянні з провідними компаніями в ШІ індустрії, такими як OpenAI, Google та Anthropic, це дуже мало. Адже кожна з них має понад 500 000 графічних процесорів.

За словами інженера NVIDIA Джима Фаня, DeepSeek навчив свою базову модель, яка називається V3, з бюджетом у $5,58 мільйона протягом двох місяців. Проте оцінити загальну вартість навчання DeepSeek-R1 складно. Використання 50 000 графічних процесорів NVIDIA потенційно могло обійтися в сотні мільйонів доларів, тож точні цифри залишаються спекулятивними.

Чому DeepSeek-R1 шокувала Кремнієву долину

DeepSeek багато в чому ламає бізнес-модель OpenAI та інших західних компаній, які працюють над власними закритими моделями ШІ. Адже DeepSeek-R1 не лише працює краще, ніж найкраща альтернатива з відкритим кодом – Llama 3 від Meta. Модель прозоро показує весь ланцюжок своїх думок у відповідях. Це завдає удару по репутації OpenAI, яка досі приховувала ланцюжки думок своїх моделей, посилаючись на комерційну таємницю та на те, що не хоче бентежити користувачів, коли модель помиляється.

Окрім цього, успіх DeepSeek підкреслює, що економні та ефективні методи розробки ШІ – це реально. Ми вже визначили, що у випадку з китайською компанією складно порахувати вартість розробки, й завжди можуть бути “сюрпризи” у вигляді багатомільярдного державного фінансування. Але наразі DeepSeek-R1, при схожому рівні точності з OpenAI o1, коштує для розробників значно дешевше. Якщо OpenAI o1 коштує $15 за мільйон вхідних токенів і $60 за мільйон вихідних токенів, то DeepSeek Reasoner API, заснований на моделі R1, пропонує $0,55 за мільйон вхідних токенів і $2,19 за мільйон вихідних токенів.

Проте хоча інновації DeepSeek є новаторськими, вони аж ніяк не забезпечили китайській ШІ-лабораторії лідерства на ринку. Оскільки DeepSeek опублікував свої дослідження, інші компанії, що займаються розробкою моделей ШІ, навчаться на них і адаптуються. Meta та Mistral, французька компанія, що займається розробкою моделей з відкритим кодом, можливо, трохи відстають, але, ймовірно, їм знадобиться лише кілька місяців, щоб наздогнати DeepSeek. Як сказав провідний дослідник ШІ в Meta Ян ЛеКун: “Ідея полягає в тому, що кожен отримує вигоду від ідей інших. Ніхто нікого не “випереджає” і жодна країна не “програє” іншій. Ніхто не має монополії на хороші ідеї. Кожен вчиться у кожного”.

Пропозиції DeepSeek, скоріше за все, продовжуватимуть знижувати ціну використання моделей ШІ, від чого виграють не тільки звичайні користувачі, але й стартапи та інші бізнеси, зацікавлені в ШІ. Але якщо розробка моделі DeepSeek-R1 з меншою кількістю ресурсів справді виявиться реальністю, це може стати проблемою для ШІ-компаній, які вклали значні кошти у власну інфраструктуру. Зокрема роки операційних та капітальних витрат OpenAI та інших можуть бути витрачені даремно.

Ринок поки що не знає остаточної відповіді на те, чи розробка ШІ в майбутньому справді буде потребувати менше обчислювальних потужностей, але вже реагує нервово падінням акцій NVIDIA та інших постачальників компонентів для дата-центрів ШІ. Це також ставить під питання доцільність проєкту Stargate, ініціативи, в рамках якої OpenAI, Oracle та SoftBank обіцяють побудувати в США дати-центри нового покоління для ШІ, на які нібито готові витратити до $500 млрд.

Але з іншого боку, якщо американські компанії все ж будуть мати надлишок потужностей для розвитку штучного інтелекту, то китайська DeepSeek зі збереженням експортних обмежень на чипи з боку США, навпаки може зіткнутися з їх гострою нестачею. Якщо все ж припустити, що обмеження ресурсів справді підштовхнуло її до інновацій та дозволило створити конкурентний продукт, то нестача обчислювальних потужностей просто не дасть йому масштабуватися, в той час, як конкуренти будуть надолужувати відставання. Тож, попри всю інноваційність DeepSeek, ще дуже рано говорити про те, що китайські компанії зможуть скласти серйозну конкуренцію західним ШІ-техногігантам, навіть якщо відкинути питання цензури та безпеки даних.

Джерело: mezha.media

Распечатать